Как массово узнать количество страниц в индексе поисковых систем с помощью Netpeak Checker

Мануалы

Индексация — важное и базовое условие оптимизации и продвижении сайта. Ваш сайт должен быть виден поисковым системам, иначе они не смогут его индексировать, он не будет появляться в выдачеи и получать органический трафик.

Есть много способов проверить индексацию сайта, я расскажу о том, как массово проверить сайт / страницы с помощью Netpeak Checker, какие могут быть причины неиндексируемости сайта, а также как ускорить индексацию.

1. Как проверить индексацию страниц в Netpeak Checker

Для проверки выполните в программе следующие действия:

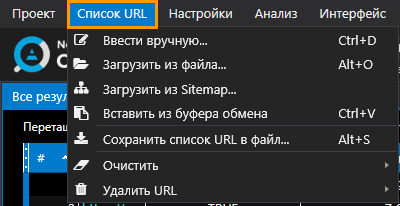

- Добавьте URL, которые хотите проанализировать. Это можно сделать несколькими способами: ввести вручную, вставить из буфера обмена, загрузить из файла и загрузить из XML Sitemap.

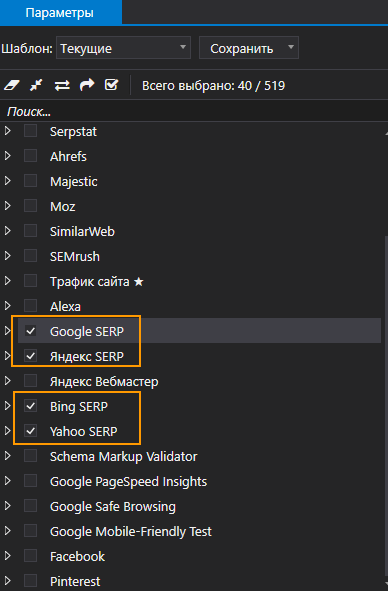

- Отметьте пункт «Индексация» в параметрах, которые соответствуют названиям поисковых систем: «Google SERP», «Яндекс SERP», «Bing SERP» и «Yahoo SERP»

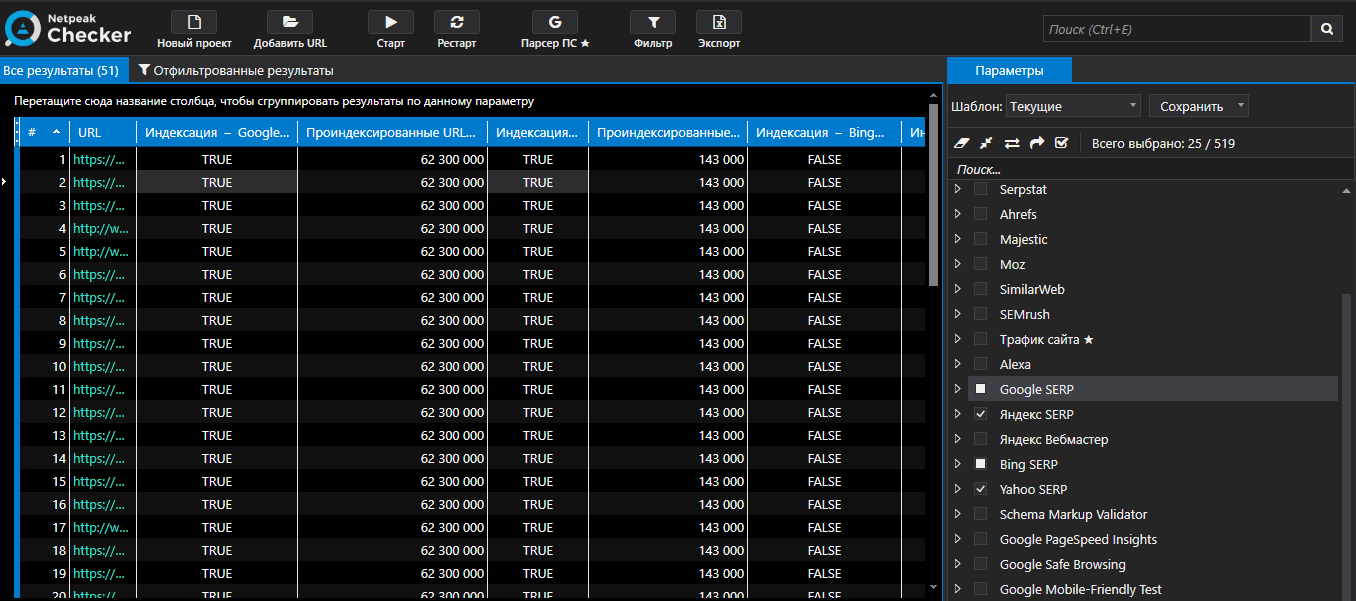

- Запустите анализ → кнопка «Старт» на верхней панели.

- По окончании сканирование в столбцах «Индексация» таблицы вы увидите значения TRUE и FALSE — проиндексировано и не проиндексировано соответственно.

- В столбце «Проиндексированные URL» показывается количество страниц, которые попали в индекс.

2. Причины, по которым сайт не индексируется

Рассмотрим самые распространённые ошибки, из-за которых страницы сайта не попадают в индекс поисковых систем.

2.1. Сайт закрыт от индексации в файле robots.txt

Из-за неправильных инструкций файла robots.txt сайт может быть не виден поисковым роботам. Ошибки могут быть из-за незнания синтаксиса или из-за того, что SEO-специалисты просто забывают «открыть» сайт и убрать лишний disallow.

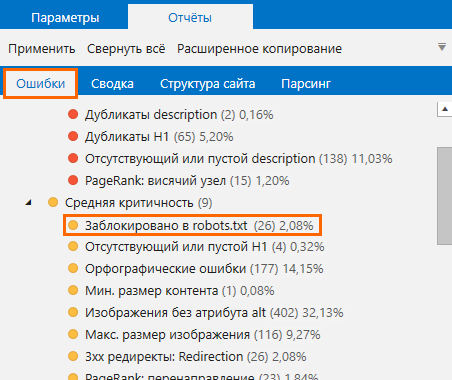

Проверить, не заблокированы страницы в robots.txt, поможет Netpeak Spider:

Поставьте сайт на сканирование и ознакомьтесь с отчётом по ошибкам:

2.2. Ошибки в директивах Meta Robots или X-Robots-Tag

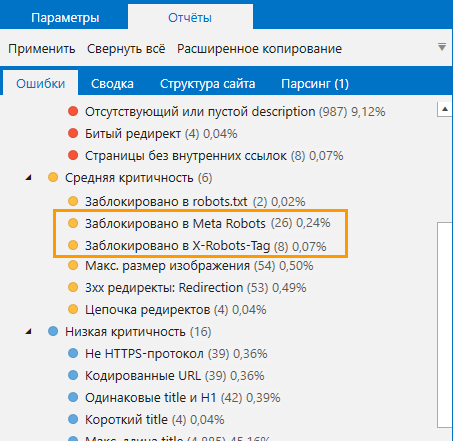

Инструкции Meta Robots или X-Robots-Tag задаются для определённых URL и потому могут закрывать от поисковых систем лишь отдельные страницы. Случайно выставленные noindex или nofollow на важных для продвижения страницах могут существенно навредить продвижению.

Проверьте сайт в Netpeak Spider: если краулер обнаружит инструкцию noindex в метаданных страницы или HTTP-заголовке, то страница будет отмечена ошибкой «Заблокировано в Meta Robots» или «Заблокировано в X-Robots-Tag»

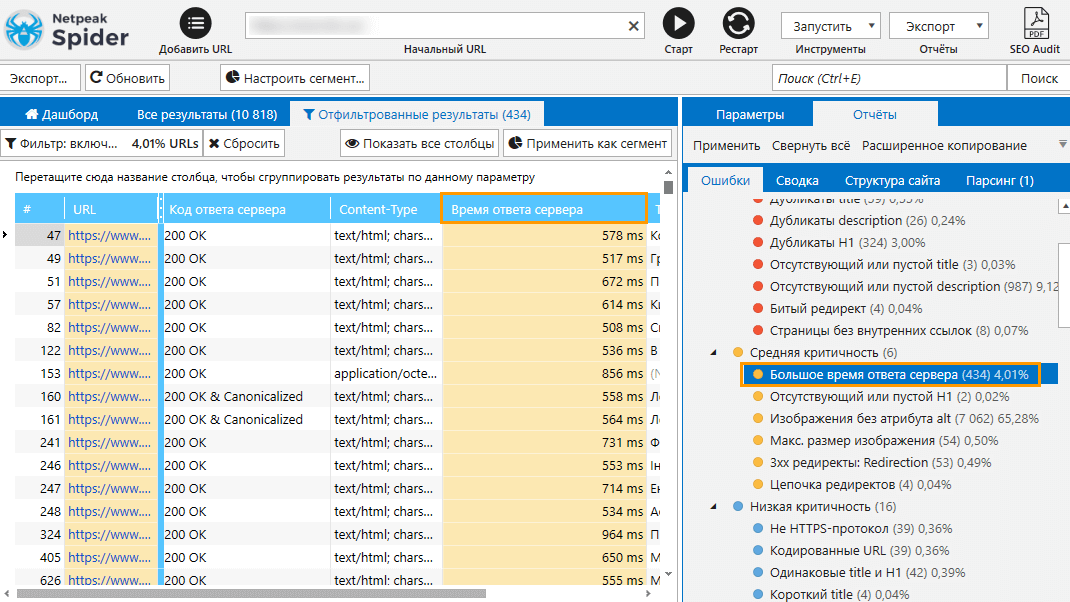

2.3. Низкая скорость загрузки

Низкую скорость загрузки сайта не любят пользователи и поисковики, отчего последние могут даже не индексировать страницы. Узнайте, какие страницы загружаются особенно долго, с помощью Netpeak Spider: после сканирования сайта изучите содержимое столбца «Время ответа сервера», а также отчёт на наличие ошибки «Большое время ответа сервера».

2.4. Отсутствие входящих ссылок на страницы

Внутренняя перелинковка помогает сделать заметными страницы для поисковиков. Если на страницу не ведёт ни одна внутренняя ссылка, во время сканирования сайта роботы могут её просто не заметить или посчитать как незначимую.

2.5. Сайт использует аутентификацию

Если на сайт можно попасть только с помощью авторизации, такой сайт не будет виден поисковым системам.

2.6. Неправильный код ответа сервера

Роботы заносят в свой индекс работающие страницы с 200 кодом ответа сервера. Если странице присвоен код 404 или 503, хотя с ней всё в порядке, поисковые системы не проиндексируют её всё равно.

3. Советы по ускорению индексации сайта

Первый и очевидный способ ускорить индексацию — исправить ошибки, описанные выше. Что ещё можно сделать для улучшения:

- Создать и поддерживать XML Sitemap. XML Sitemap — это служебный файл, который предоставляет роботам список страниц для индексации. Подробнее об этом читайте в посте: «Что такое XML Sitemap, как его создать и проверить».

- Добавить HTML карту сайта — HTML файл, содержащий ссылки на все самые приоритетные страницы сайта. Детали в посте «Что такое HTML-карта, и как её создать».

- Организуйте навигацию на сайте. Навигация позволяет легче ориентироваться посетителям, а также ускоряет сканирование и индексацию.

- Как можно чаще публикуйте новый контент. Поисковики наведываются чаще на те сайты, у которых появляется свежий контент. Старайтесь обновлять минимум раз в неделю.

- Получайте обратные ссылки. Помимо того, что обратные ссылки положительно влияют на рейтинг и репутацию сайта, они также помогают улучшить индексацию. Читайте наш пост «15 способов получить обратные ссылки бесплатно», чтобы узнать, как получить бэклинки.

Подводим итоги

Чтобы сайт отображался в поисковой выдаче, откройте его для поисковых систем → так они смогут сканировать и индексировать его. Массово проверить страницы сайта поможет Netpeak Checker.

Если вы обнаружили, что страницы плохо индексируются, убедитесь, что:

- сайт открыт к индексации,

- в директивах Meta Robots или X-Robots-Tag нет ошибок,

- у сайта высокая скорость загрузки,

- реализована правильная внутренняя перелинковка,

- у всех страниц проставлен правильный код ответа сервера.

А у вас были проблемы с индексацией? Как справлялись? Пишите в комментариях 😊