Чеклист по регулярному мониторингу сайта с Netpeak Spider и Checker

Кейсы

Работая с сайтами, рано или поздно сталкиваешься с проблемами, когда что-то сломалось, не загружается, не выводится. Когда это происходит, важно как можно быстрее обнаружить ошибку и исправить её.

В рамках этого поста я поделюсь своим чеклистом проверки сайта на ошибки, которые чаще всего встречались у меня на практике. Особенно актуально для больших сайтов, ошибки на которых могут нанести серьёзный ущерб вашему бизнесу.

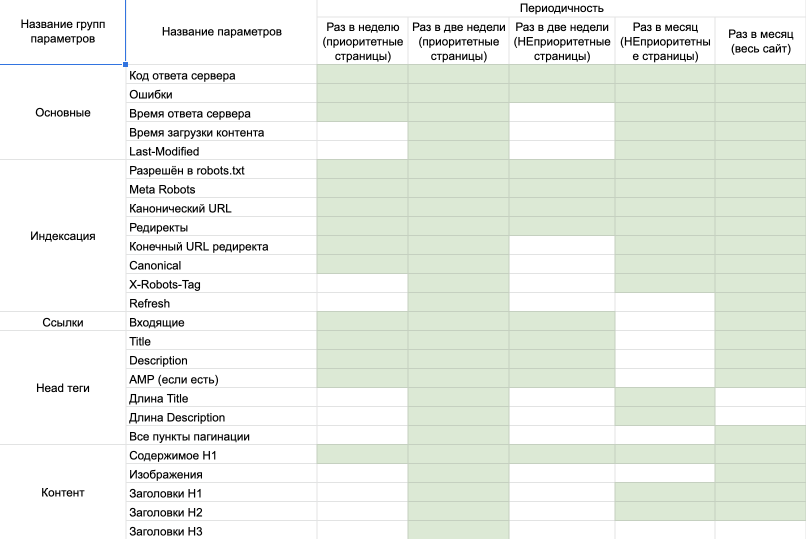

1. Кластеризация страниц

Перед тем, как использовать чеклисты, советую вам разделить ваши посадочные страницы на приоритетные и неприоритетные:

- Приоритетные — это те страницы, которые важны для вас. В моём случае это самые трафиконосные страницы (включая главную).

- Неприоритетные, по логике, это все остальные посадочные страницы.

Так как это будет список URL, не забываем каждый раз обязательно пробивать в Netpeak Checker наличие страниц в индексе нужных нам поисковых систем.

Читайте также: «Как массово узнать количество страниц в индексе поисковых систем с помощью Netpeak Checker».

Мой чеклист я разделил на три части (кроме приоритетных и неприоритетных):

- Пробивка раз в неделю.

- Пробивка раз в две недели.

- Пробивка раз в месяц.

Это сделано, чтобы важные параметры пробивались чаще. Это всё условно, вы, конечно же, можете менять частоту и параметры пробивки :)

Для удобства чеклист я сделал в визуальном и текстовом представлении.

2. Чеклист проверки приоритетных страниц

Перед настройкой нужно подготовить список URL приоритетных страниц, то есть проверка будет проходить по заданным URL.

- Раз в неделю с помощью Netpeak Spider пробиваем заданный список заданный список приоритетных URL по следующим настройкам и параметрам.

- Настройки

- Основные → Базовые настройки сканирования → Сканировать только внутри разделов (больше ничего).

- Продвинутые → Учитывать ВСЕ инструкции по индексации.

- Параметры

- Основные:

- Код ответа сервера.

- Ошибки.

- Время ответа сервера.

- Индексация:

- Разрешён в robots.txt.

- Meta Robots.

- Canonical URL.

- Редиректы.

- Конечный URL редиректа.

- Canonical.

- Ссылки: Входящие → Внутренние ссылки.

- Head теги:

- Title.

- Description.

- AMP (если есть).

- Контент: содержимое H1.

- Основные:

- Настройки

- Раз в две недели с помощью Netpeak Spider пробиваем заданный список приоритетных URL по следующим настройкам и параметрам.

- Настройки

- Используем настройки, которые прописаны в пункте 1.1.

- В «Продвинутые» дополнительно используем все параметры «Сканировать ссылки из тега <link>»

- Параметры

- Основные (кроме тех, что мы отметили выше):

- Время загрузки контента.

- Last-Modified.

- Индексация (кроме тех, что мы отметили выше):

- X-Robots-Tag.

- Refresh.

- В разделе «Ссылки» ничего нового не добавляем.

- Head теги (кроме тех, что мы указали выше):

- Длина Title.

- Длина Description.

- Контент (кроме тех, что мы отметили выше):

- Изображения.

- Заголовки H1.

- Заголовки H2.

- Заголовки H3.

- Основные (кроме тех, что мы отметили выше):

- Настройки

3. Чеклист проверки неприоритетных страниц

Перед настройкой нужно подготовить список URL неприоритетных страниц.

- Раз в две недели с помощью Netpeak Spider пробиваем заданный список неприоритетных URL по следующим настройкам и параметрам.

- Настройки

- Основные → Базовые настройки сканирования → Сканировать только внутри разделов (больше ничего).

- Продвинутые → Учитывать ВСЕ инструкции по индексации/

- Параметры

- Основные:

- Код ответа сервера.

- Ошибки.

- Индексация:

- Разрешён в robots.txt.

- Meta Robots.

- Canonical URL.

- Редиректы.

- Ссылки: Входящие → Внутренние ссылки.

- Head теги:

- Title.

- Description.

- AMP (если есть).

- Контент: содержимое H1.

- Основные:

- Настройки

- Раз в месяц с помощью Netpeak Spider пробиваем заданный список неприоритетных URL по следующим настройкам и параметрам.

- Настройки

- Используем настройки, которые прописаны в пункте 1.1.

- В «Продвинутые» дополнительно используем все параметры «Сканировать ссылки из тега <link>»

- Параметры

- Основные (кроме тех, что мы отметили выше):

- Время ответа сервера

- Время загрузки контента.

- Last-Modified.

- Индексация (кроме тех, что мы отметили выше):

- X-Robots-Tag.

- Конечный URL редиректа.

- Canonical

- В разделе «Ссылки» ничего нового не добавляем.

- Head теги (кроме тех, что мы указали выше):

- Длина Title.

- Длина Description.

- Контент (кроме тех, что мы отметили выше):

- Заголовки H1.

- Заголовки H2.

- Основные (кроме тех, что мы отметили выше):

- Настройки

3. Чеклист проверки всего сайта

Сканируя определённые страницы, можно не увидеть ошибки и проблемы на новых страницах, а это очень важный момент. Поэтому, чтобы увидеть общую картину сайта, я советую вам также не забывать пробивать в Netpeak Spider весь ваш сайт.

Раз в месяц с помощью Netpeak Spider проверяем сайт по следующим настройкам и параметрам.

- Настройки

- Основные → Базовые настройки сканирования →

- Сканировать только внутри раздела (или поддомены если есть).

- Проверять изображения.

- Продвинутые → Учитывать ВСЕ инструкции по индексации.

- Продвинутые → дополнительно используем все параметры «Сканировать ссылки из тега <link>»

- Основные → Базовые настройки сканирования →

- Параметры

- Основные:

- Код ответа сервера.

- Ошибки.

- Время ответа сервера.

- Время загрузки контента.

- Last-Modified.

- Индексация:

- Разрешён в robots.txt.

- Meta Robots.

- Canonical URL.

- Редиректы.

- Конечный URL редиректа.

- X-Robots-Tag.

- Refresh.

- Canonical.

- Ссылки: Входящие → Внутренние ссылки.

- Head теги:

- Title.

- Description.

- AMP (если есть).

- Контент:

- Изображения.

- Содержимое H1.

- Заголовки H1.

- Заголовки H2.

- Основные:

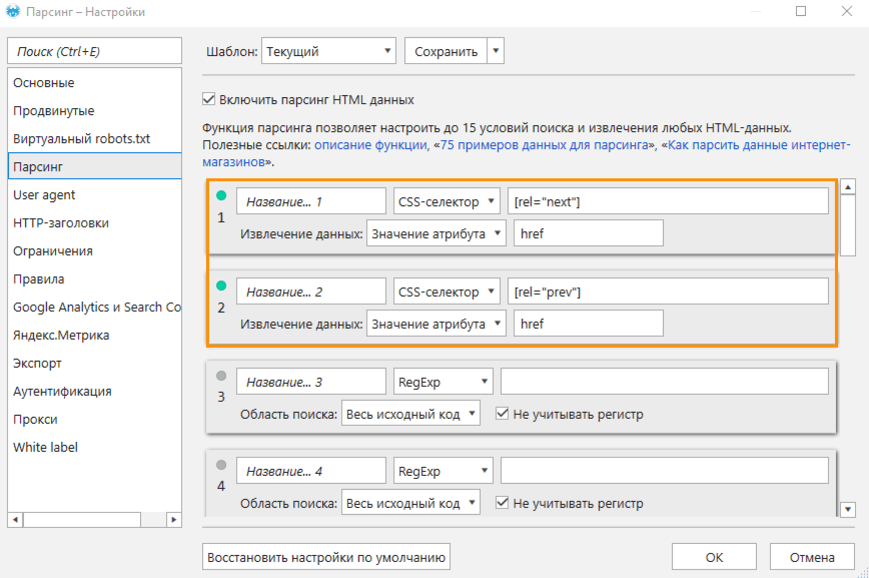

Если необходимо проверить пагинацию старого образца и собрать ссылки на страницы пагинации в теге , задайте их виде параметров парсинга.

4. Кейсы

Благодаря данным проверкам мы сумели вовремя зафиксировать и исправить очень много ошибок, например:

- Обнаружили, что неправильно были настроены редиректы после реструктуризации категории.

- Обнаружили дубли метатегов на приоритетных страницах.

- Программисты не перенесли SEO тексты на некоторые страницы после переезда.

- Обнаружили, что некоторые важные страницы закрыли от индексации.

- Обнаружили ошибки в редиректах во время смены языковой версии сайта.

У Netpeak Spider и Checker есть бесплатные версии без ограничений по времени использования, с помощью которых вы сможете проводить регулярный мониторинг сайта, а также работать с другими базовыми функциями программ.

Чтобы начать пользоваться бесплатными Netpeak Spider и Checker, просто зарегистрируйтесь, скачайте и установите программы — и вперёд! 😉

Зарегистрироваться и установить бесплатные версии

P.S. Сразу после регистрации у вас также будет возможность потестировать весь платный функционал, а затем сравнить все наши тарифы и выбрать для себя подходящий.Подводим итоги

Имея в арсенале такой софт как Netpeak Spider и Checker, мы можем без особых усилий настроить процесс систематической проверки важных и не приоритетных страниц на сайте.

Для удобства советую сохранить шаблоны настроек, чтобы уменьшить время на настройку в следующий раз.

Поделитесь в комментариях вашими чеклистами для аудитов :)