Продвинутые настройки Netpeak Spider для профессионального поиска SEO-ошибок на сайте

Кейсы

Одно из сильных преимуществ краулера Netpeak Spider — фокус на устранении SEO-ошибок. После сканирования сайта программа показывает более сотни разных отчётов, а в блоке «Информация» всегда можно найти описания каждой ошибки, рекомендации по исправлению и ссылки на полезные ресурсы.

И самое интересное, что вы можете не ограничиваться лишь стандартным сканированием, которое Netpeak Spider выполняет по умолчанию. И в этом посте я расскажу о том, как настроить краулер для поиска небанальных SEO-ошибок сайта.

1. Варианты настроек Netpeak Spider

1.1. Основные настройки сканирования

Для выполнения детальных проверок сайта мы в Netpeak Spider реализовали гибкие настройки сканирования, которые можно изменять под каждую конкретную задачу и даже сохранять в шаблоны для будущего использования.

1.1.1. Скорость сканирования

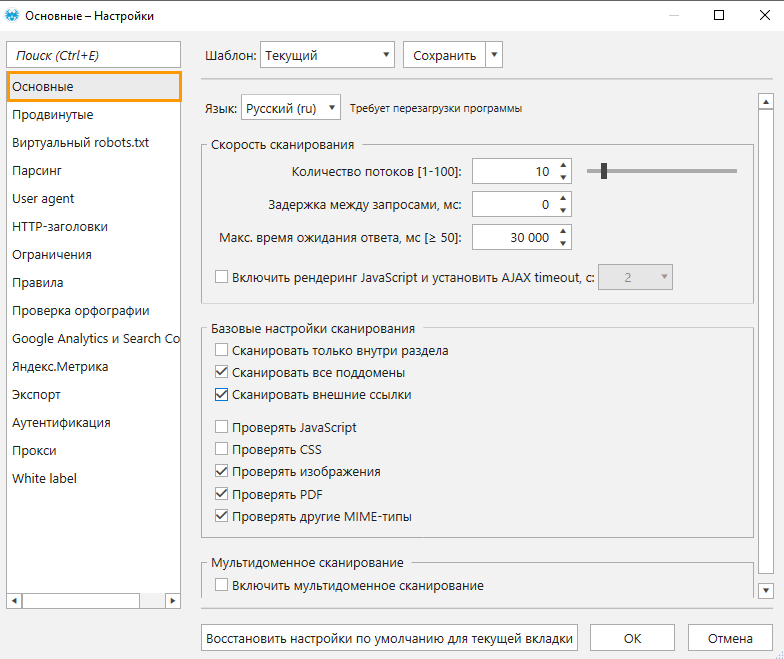

Предлагаю начать с первого пункта настроек на вкладке «Основные», который отвечает за скорость краулинга.

По умолчанию всегда стоит 10 потоков, но если вы хотите проверить работоспособность вашего сайта во время большой нагрузки, вы можете увеличить количество потоков до 40-50.

Функция рендеринга JavaScript пригодится, когда необходимо проверить работу элементов, которые подгружаются с помощью JavaScript.

1.1.2. Базовые настройки сканирования

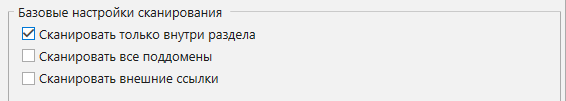

Здесь вы можете выбрать, откуда и какие типы документов программа должна просканировать. Например, вы хотите искать ошибки только в определённой папке сайта (допустим, в блоге), тогда укажите её адрес в поле «Начальный URL» (example.com/blog) и отметьте пункт «Сканировать только внутри раздела».

Если необходимо просканировать все страницы поддоменов и внешние ссылки (например, найти битые ссылки на внешние ресурсы), тогда отметьте следующие два пункта.

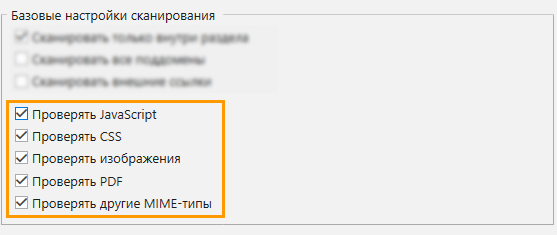

Чтобы проверить файлы JavaScript, CSS и другие файлы, отметьте соответствующие чекбоксы

Эти функции особенно пригодятся, когда нужно проверить сайт на битые картинки или другие файлы, которые ответили не 200 OK.

1.1.3. Мультидоменное сканирование

Мультидоменное сканирование — это функция, которая позволяет выполнить синхронное сканирование нескольких доменов вглубь в рамках одной сессии.

Включите её, если хотите быстро получить отчёты по нескольким проектам в одном окне.

Мультидоменное сканирование доступно пользователям Netpeak Spider на Pro-тарифе. Хотите получить доступ к этой и другим PROфессиональным функциям? А именно:

- white label отчётам с возможностью брендирования и добавлением комментария,

- выгрузке поисковых запросов из Google Search Console и Яндекс.Метрики,

- экспорту отчётов на Google Drive / Sheets и др.

Тогда нажимайте на кнопку, чтобы приобрести тариф Pro, и вперёд получать самые крутые инсайты!

1.2. Продвинутые настройки

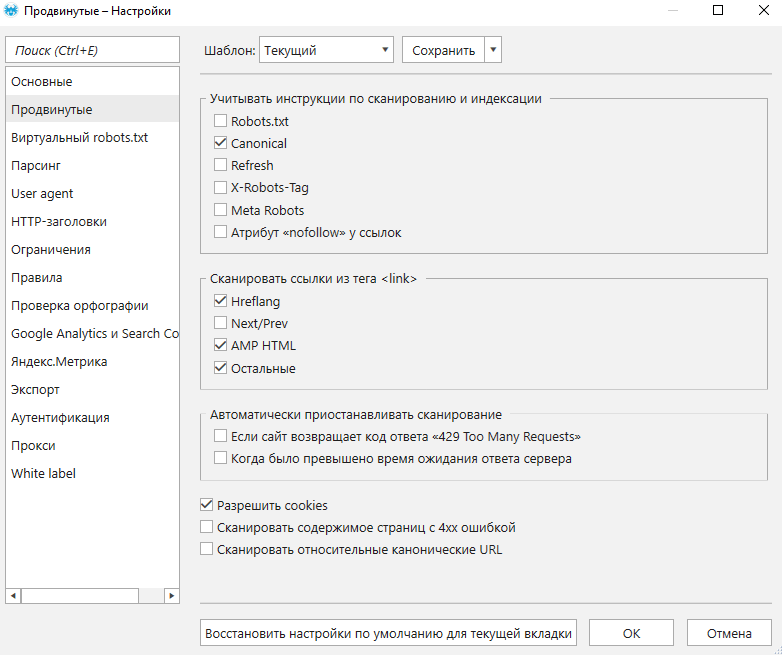

На этой вкладке настроек можно:

- включить или выключить учёт инструкций индексации и сканирования;

- указать, нужно ли переходить по ссылкам из различных тегов и сканировать их;

- разрешить сохранение cookie-файлов;

- включить / отключить сканирование относительные канонические URL.

А теперь я расскажу, как всё это использовать:

- Игнорируя инструкции индексации и сканирования, вы можете собрать все страницы сайта: в таблицу попадут даже URL, которые скрыты от поисковых роботов → так вы сможете проверить, а вдруг туда попадут те, которые должны быть индексируемыми.

- Для мультиязычных сайтов проверка корректности настройки атрибутов hreflang — это обязательный этап. К тому же программа строит более 10 отчётов, которые помогут оптимизировать перелинковку между различными языковыми версиями страниц на вашем сайте.

- Аналогично со ссылками из других тегов: чтобы найти как можно больше проблемных страниц, включите эти галочки.

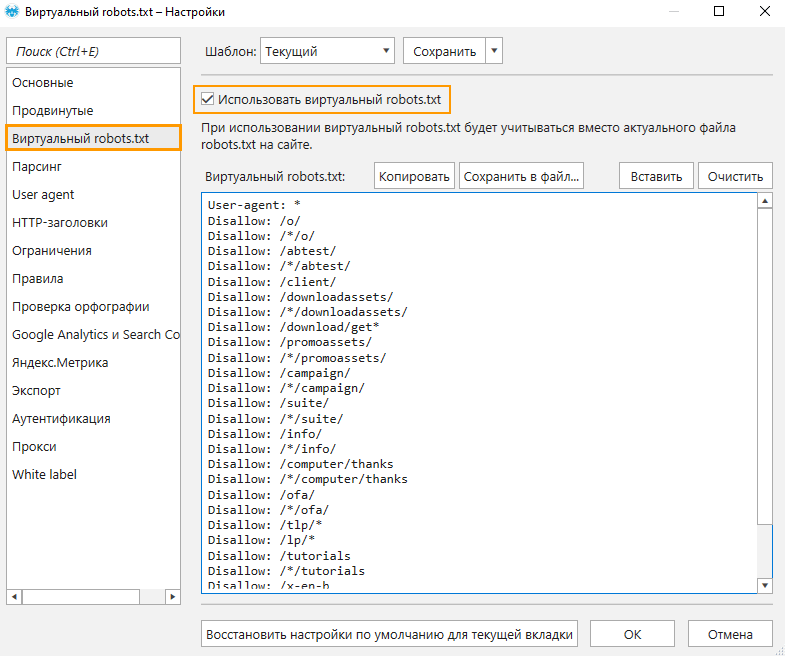

1.3. Виртуальный robots.txt

Здесь вы можете проверить работу различных вариаций этого файла, не внося изменения на сайте.

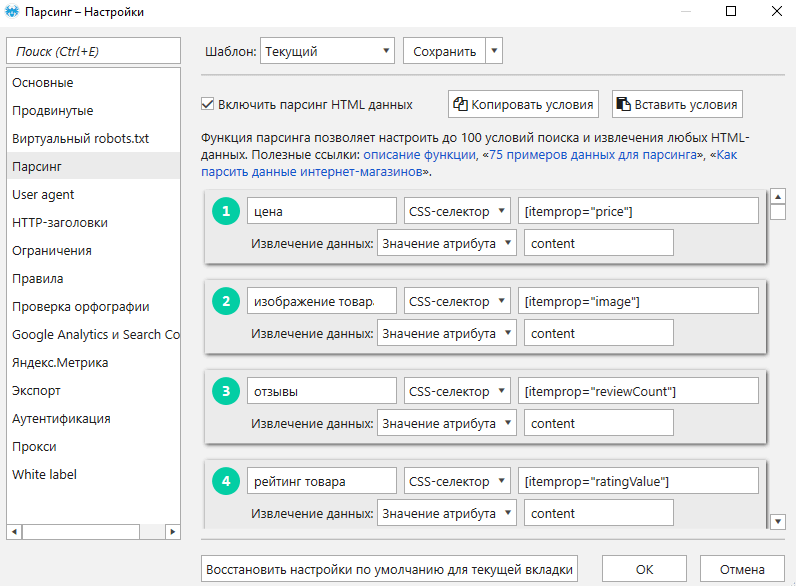

1.4. Парсинг

Функция парсинга в Netpeak Spider позволяет собирать любые данные с сайтов (цены, характеристики, отзывы и т.д.), находить листинги с малым количеством товаров или даже страницы, где отсутствует трекер аналитики, и многое другое.

Кстати, у нас на канале есть видео про эту функцию, обязательно посмотрите, чтобы лучше в ней разбираться 😊

Так с помощью парсинга можно искать определённый тег на странице, который отвечает за отображение элемента на сайте.

Столько раз, сколько краулер найдёт этот тег на странице, столько и будет карточек товаров на этом листинге. Например, если их меньше, чем должно быть, вы сможете быстро отфильтровать и изучить нужный отчёт.

Чтобы начать пользоваться бесплатным Netpeak Spider, просто зарегистрируйтесь, скачайте и установите программу — и вперёд! 😉

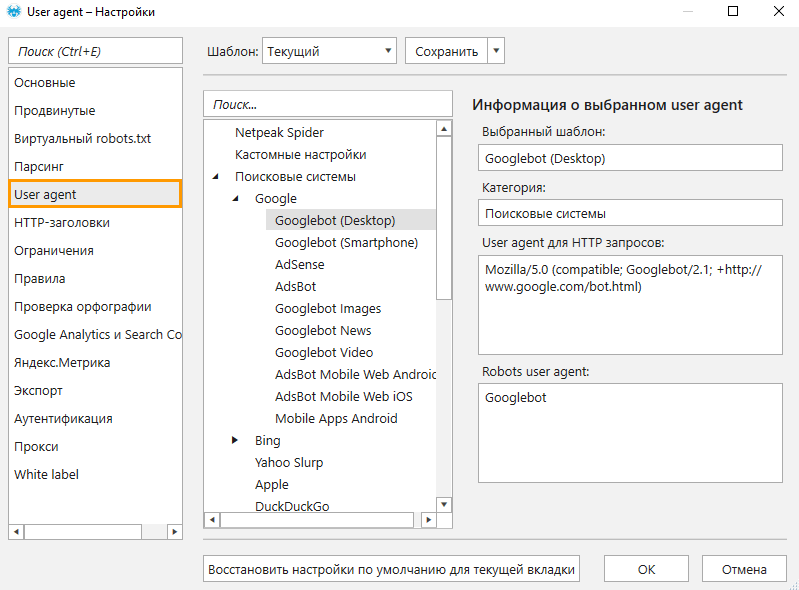

1.5. User Agent

На вкладке «User Agent» вы можете задать разные значения этого заголовка запроса к серверу и проверить работу вашего сайта, просканировав его с самых популярных User Agent: например, Googlebot, Google Chrome, YandexBot, и нашего встроенного NetpeakSpiderBot. Также можно просканировать сайт с учётом разных браузеров и устройств.

Важно: после сканирования убедитесь, что результаты именно такие, как вы ожидали, потому что иногда сайт отдаёт ошибочный контент для определённых юзер-агентов, а для стандартных ботов — нормальный. Или же наоборот, когда для поисковых систем отдаются страницы с ошибками — это явно не сыграет пользу в оптимизации сайта. Никто не застрахован от таких ошибок, но каждый может перепроверить сайт и избежать последствий 😉

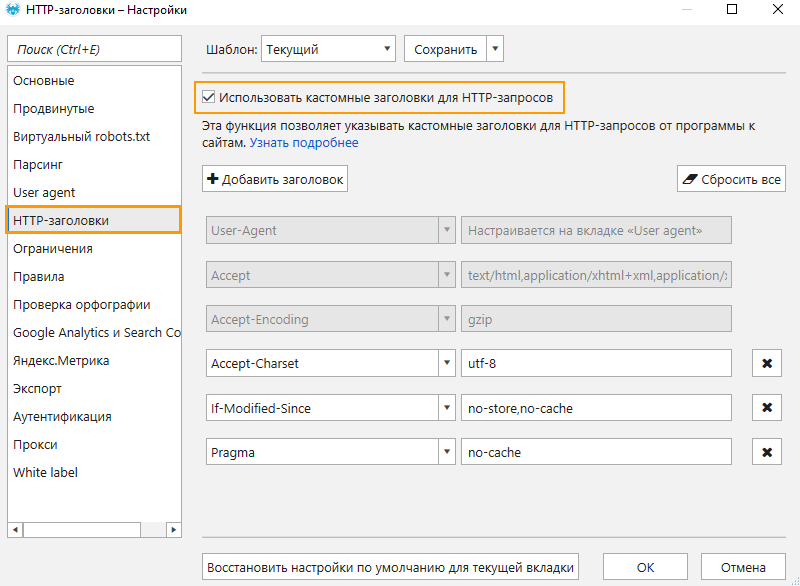

1.6. HTTP-заголовки

Советую перепроверять сайт и с помощью различных значений в тех HTTP-заголовках запроса к серверу, которые влияют на отображаемый контент.

Например, вы можете проверить, какой контент отдаётся с разных языков, если у вас мультиязычный сайт. Или проверьте корректность настройки 304 кода ответа с помощью заголовка «If-Modified-Since».

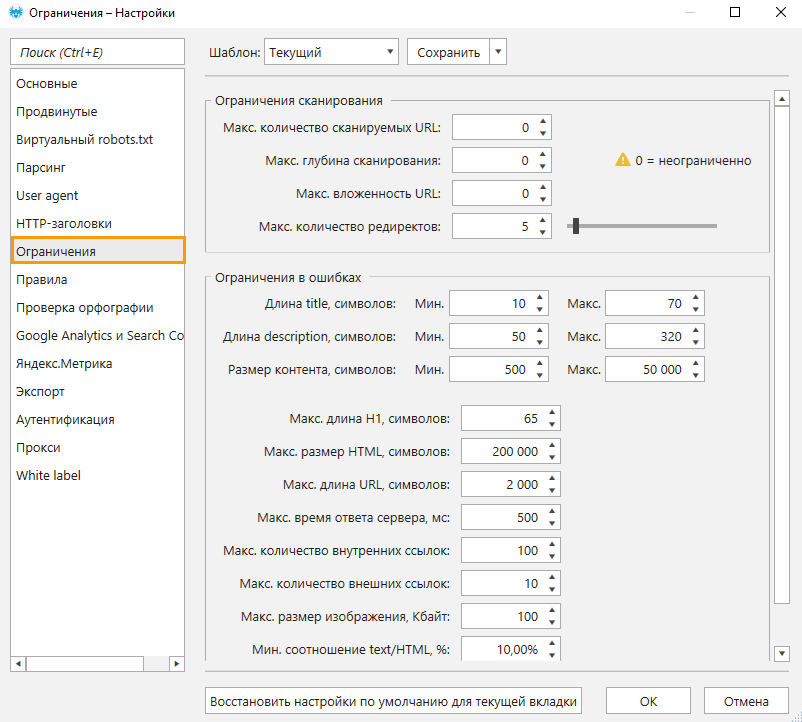

1.7. Ограничения

Так как у каждого специалиста свой подход и предпочтения, а у каждого проекта — разные значения нормы для показателя отказов, мы дали возможность кастомизировать определения ошибок. Указать то, что должно считаться ошибкой для вашего сайта, можно на вкладке «Ограничения»: например, Netpeak Spider будет помечать ошибкой все страницы, с которых больше трёх или пяти внешних ссылок, и так далее. Также вы можете указать, как глубоко хотите сканировать сайт, и сколько страниц хотите получить.

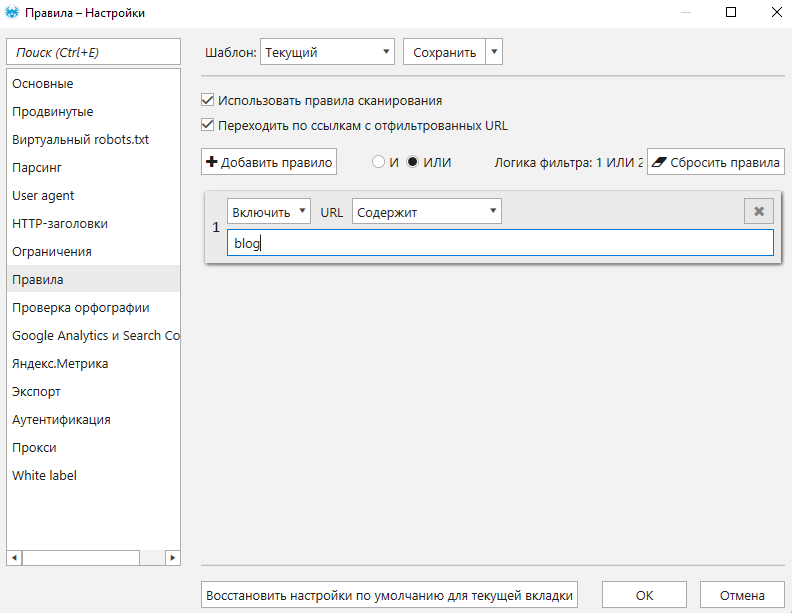

1.8. Правила

Чтобы ограничить сканирование определённой части сайта, используйте вкладку «Правила» → тут вы сможете добавить или исключить из сканирования страницы по составу URL: к примеру, просканировать только страницы определённой категории блога или те, что в URL содержат название бренда. Это позволит ускорить сканирование и сфокусироваться на нужных вам страницах.

Можно также ограничить сканирование не только по блогу, но и по поддомену и вообще отфильтровать URL по определённому сегменту.

Правил можно создавать огромное множество, а также комбинировать их по логике «И» / «ИЛИ».

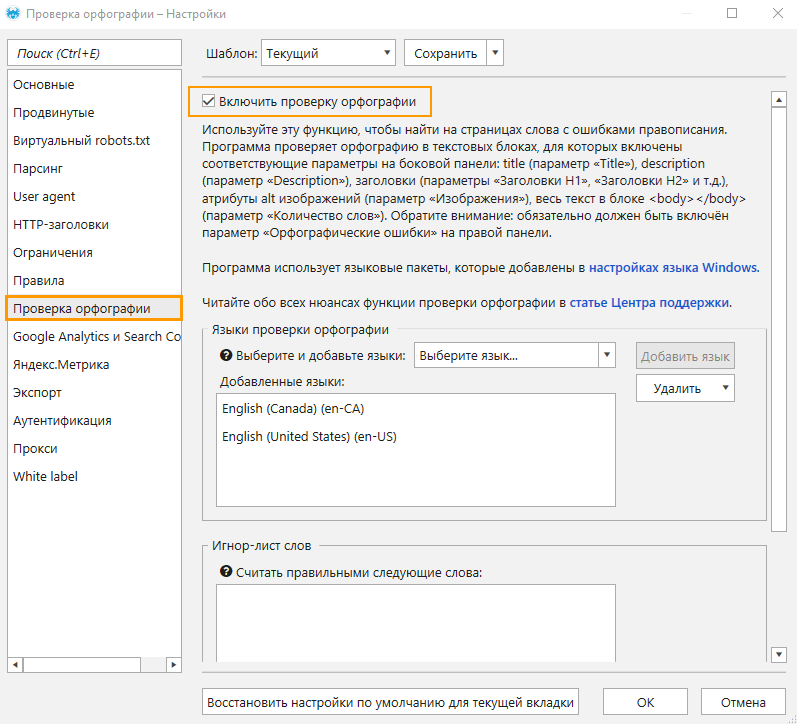

1.9. Проверка орфографии

Эта функция поможет обнаружить орфографические ошибки на всех страницах сайта. Для её активации отметьте самый верхний чекбокс, затем выберите языки, на которые следует проверять. В поле игнор-лист можно вписать слова, которые не нужно считать ошибкой.

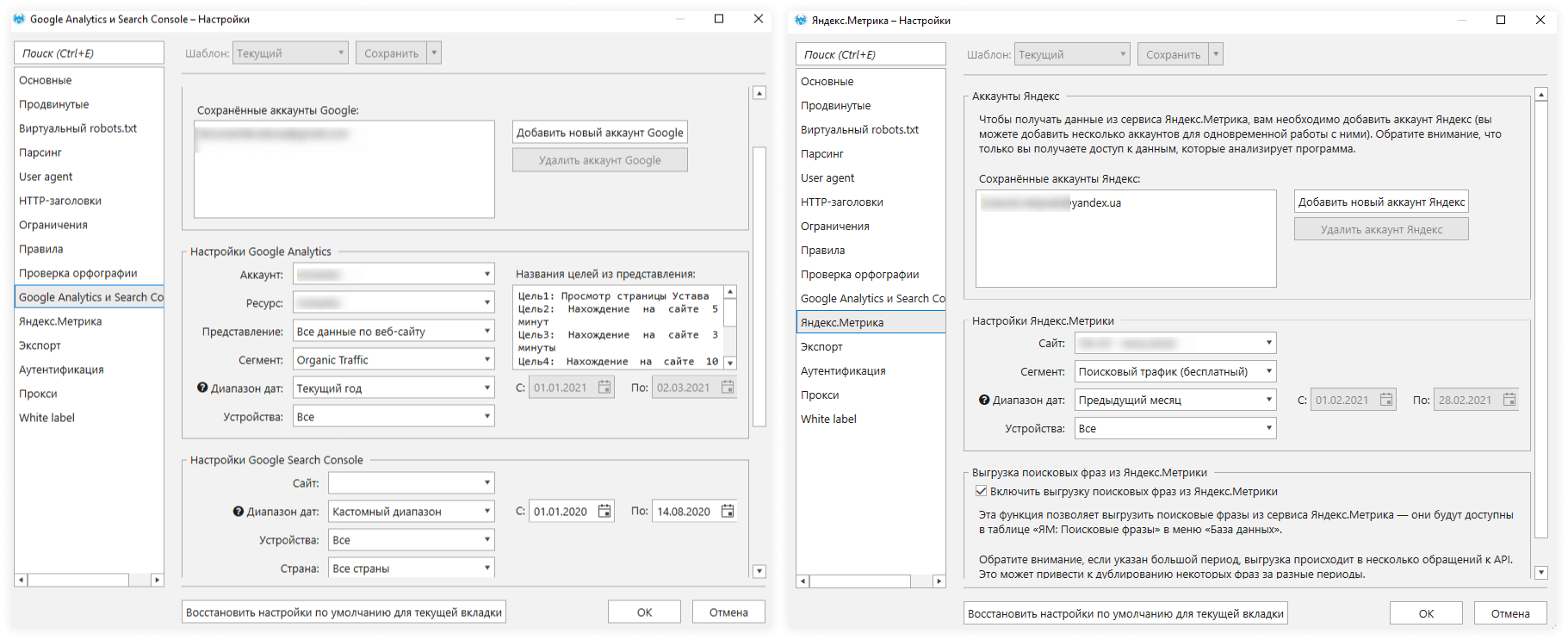

1.10. Google Analytics и Google Search Console / Яндекс.Метрика

Не буду тут сильно углубляться, скажу лишь, что анализ трафика и поисковых слов с разных сегментов и дат однозначно поможет найти хороший инсайты и точки роста. Особенно это будет полезно тем, кто продвигает сайт под Google и Яндекс: в рамках одного Netpeak Spider вы можете быстро проанализировать данные из двух поисковых систем.

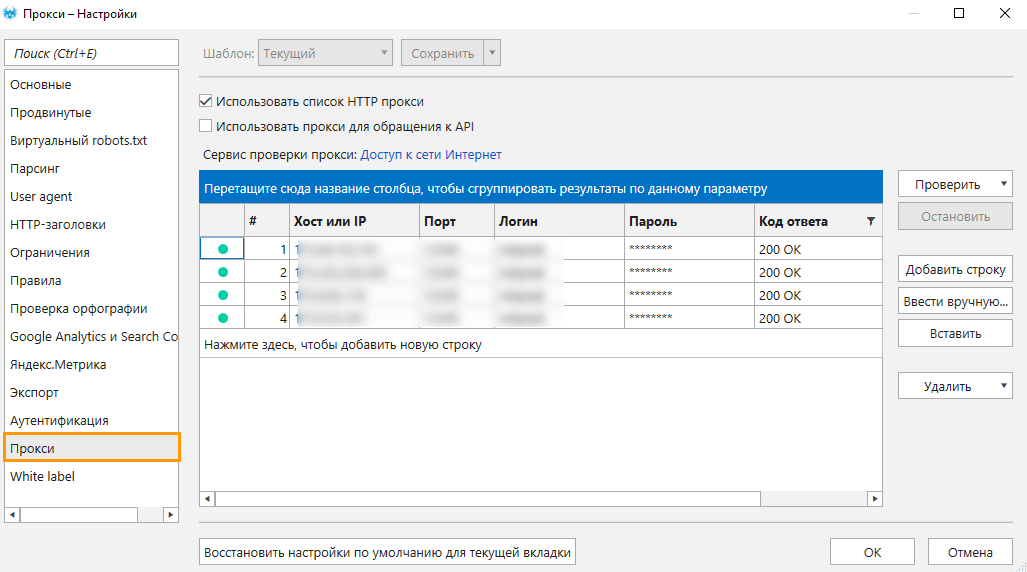

1.11. Прокси

Это может быть неочевидно, но эта функция помогает находить скрытые ошибки. Используя прокси различных стран или регионов, вы можете проверить корректность отображения нужной версии сайта для определённого города или языка.

2. Сегментация полученных результатов для работы с ошибками

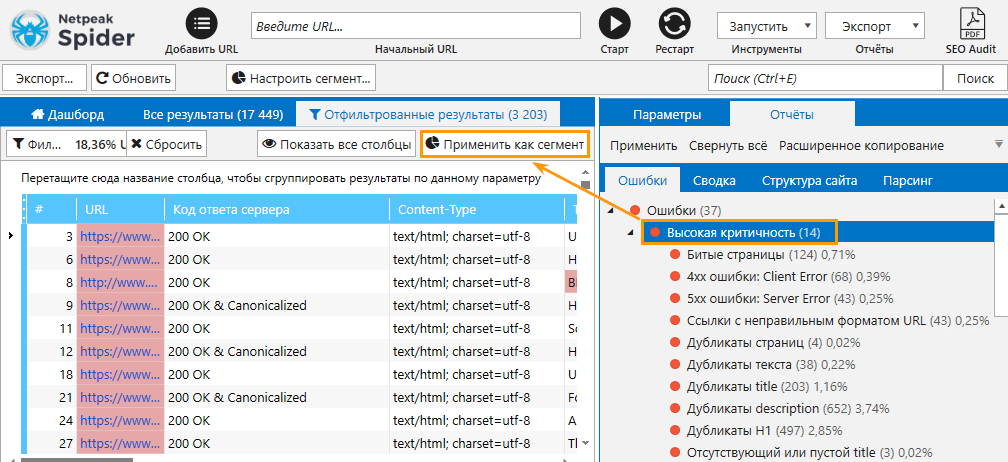

Сегмент в Netpeak Spider — это своего рода продвинутый фильтр, он позволяет перестроить базовые отчёты и детально рассмотреть все возможные проблемы в определённой группе страниц.

Например, в качестве сегмента можно применять страницы, на которых были найдены ошибки высокой критичности.

После применения сегмента перейдите на вкладку «Структура сайта» → так можно быстро получить инсайт, в каком разделе было найдено больше всего критичных ошибок.

Также определённый раздел сайт может быть сегментом → нажмите на него, затем на кнопку «Применить как сегмент» и перейдите в отчёты по ошибкам, чтобы узнать, какие распространены именно в этом разделе.

По своему опыту скажу, что просканировав один раз весь сайт, вы можете провести несколько часов, рассматривая его различные сегменты, ведь их можно настраивать по любому набору параметров или с помощью преднастроенных фильтров. Например, можно посмотреть все карточки товаров, где есть изображения без alt-тега, или все статьи на блоге с малым количество входящих ссылок, у которых небольшой объём трафика по данным из Google Analytics или Яндекс.Метрики.

Не бойтесь экспериментировать с сегментами, именно они чаще всего приводят к нестандартным инсайтам 😉

Подводим итоги

Поиск и помощь в устранении SEO-ошибок на сайте — это одна из главных задач Netpeak Spider, а с помощью гибких настроек сканирования, функции сегментации данных и более сотни отчётов вы можете рассмотреть свой сайт будто под микроскопом.

Оставляйте свои вопросы в комментариях под постом. Огромного трафика вам и хорошего дня 😊