Как провести аудит большого сайта (+100К страниц) с помощью Netpeak Spider

Мануалы

Сканирование и проверку состояния сайта необходимо проводить регулярно, если вы хотите, чтобы ваш сайт попадал в топ выдачи, привлекал трафик и приносил конверсии. Краулинг поможет обнаружить проблемы, которые препятствуют продвижению сайта. Проводить проверку достаточно раз 1-2 месяца, но когда дело касается больших сайтов с более 100 тысяч URL, задача усложняется.

И в этом посте я расскажу, как проводить сканирование больших ресурсов в Netpeak Spider.- 1. Определение задач SEO-аудита крупных сайтов

- 2. Настройки в программе перед запуском сканирования

- 3. Анализ результатов сканирования

1. Определение задач SEO-аудита крупных сайтов

От задач, которые стоят перед вами, будет зависеть, какие параметры и настройки вы будете применять перед сканированием. Предлагаю рассмотреть самые основные и распространённые:

1.1. Сбор полного списка URL

Чтобы собрать список всех страниц сайта в Netpeak Spider, достаточно:

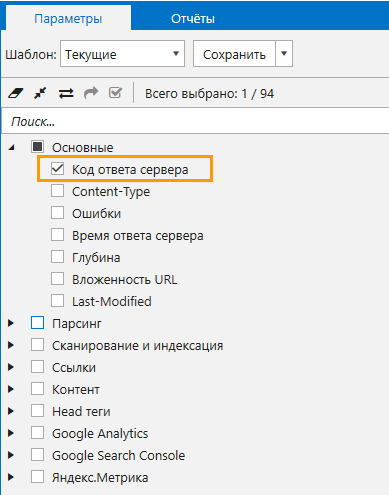

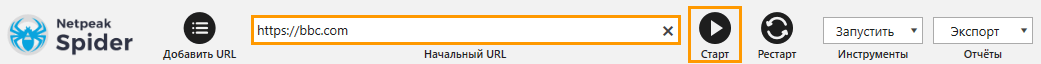

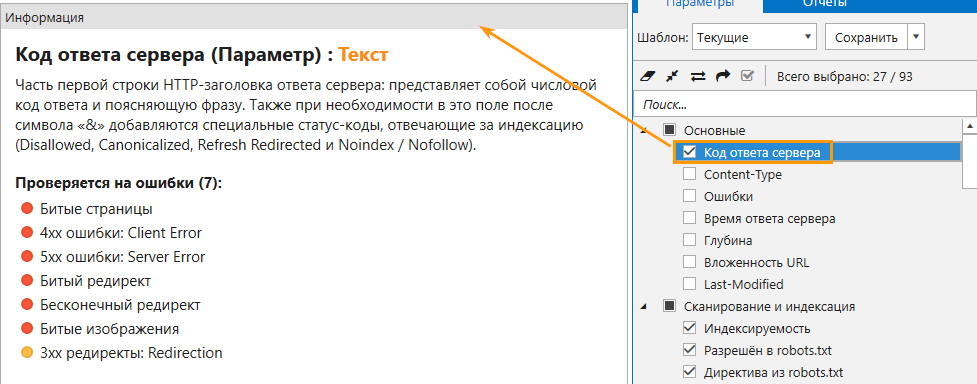

- Выбрать параметр «Код ответа сервера» на боковой панели.

- Вставить адрес сайта и нажать на «Старт»

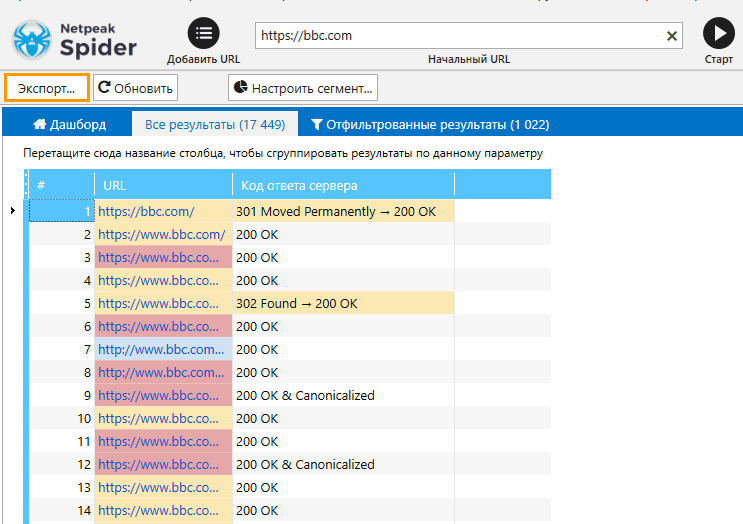

- Дождаться, когда программа закончит сканирование, и ознакомиться со списком страниц в основной таблице. Чтобы выгрузить данные из таблицы, нажать на кнопку «Экспорт».

1.2. Проверка структуры сайта

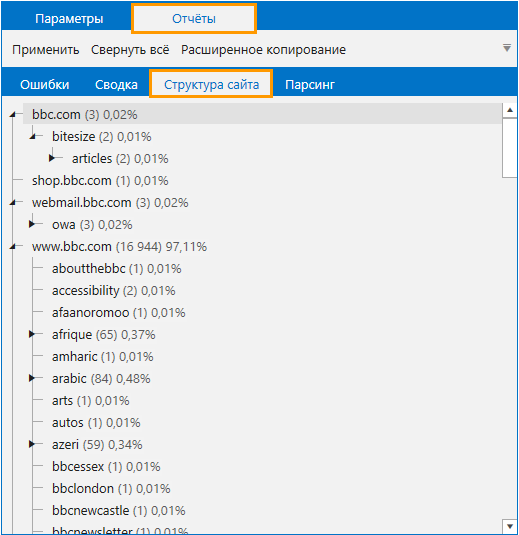

Анализ структуры сайта позволяет увидеть и проанализировать строение взаимосвязей внутри сайта, а также понять, как можно улучшать и оптимизировать структуру. Чтобы получить данные о структуре сайта в Netpeak Spider, достаточно запустить сканирование сайта без преднастроенных параметров, а после окончания анализа открыть вкладку «Отчёты» → «Структура сайта».

Чтобы экспортировать структуру, перейдите в меню «Экспорт» и выберите отчёт «Структура сайта». Также всю структуру можно скопировать в буфер обмена → для этого просто нажмите на кнопку «Расширенное копирование».

Обратите внимание, что программа формирует структуру на основе структуры URL.

1.3. Проверка индексации и сбор индексируемых страниц

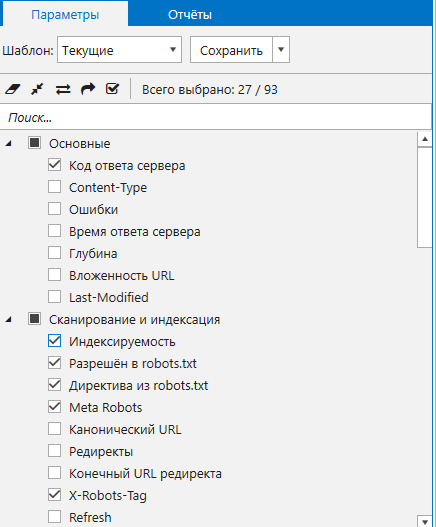

Чтобы проверить, как индексируется сайт, а также получить список индексируемых URL, достаточно перед сканированием в программе отметить нужные пункты в разделе «Сканирование и индексация» и пункт «Код ответа сервера» в основных параметрах.

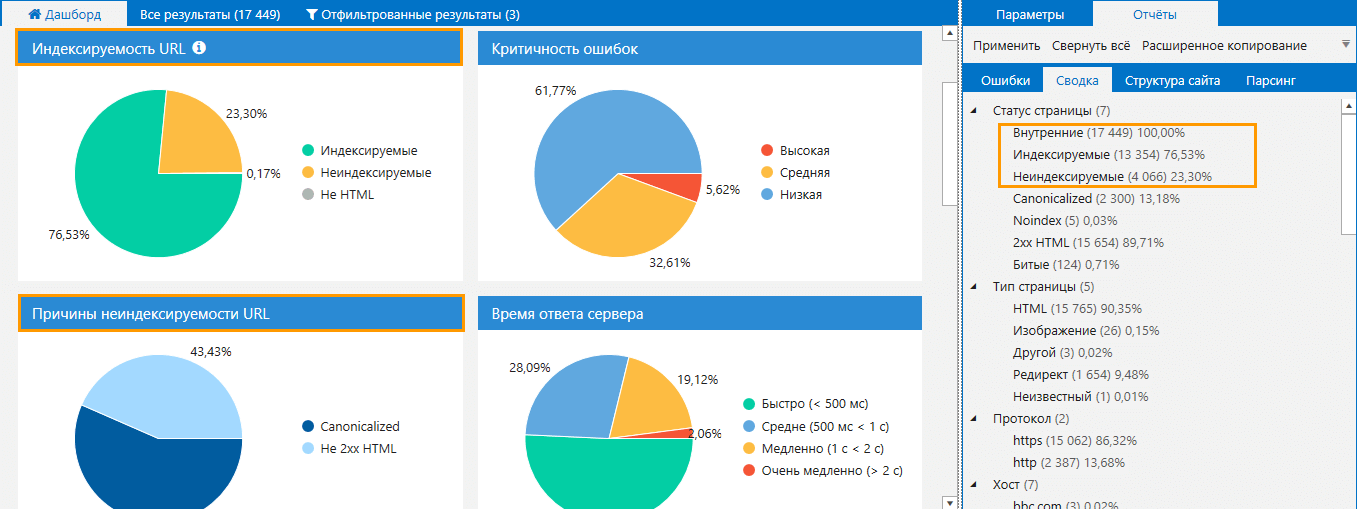

Все данные по индексации вы увидите в разделе «Сводка» и на Дашборде. Вы можете отсортировать список страниц по определённым показателям кликом на нужную диаграмму на дашборде либо на раздел в сводке.

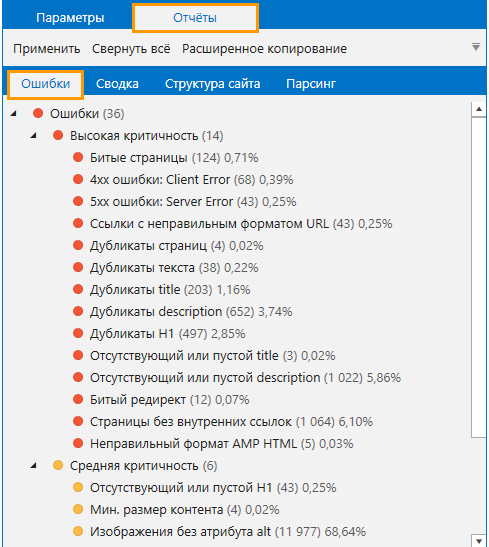

1.4. Поиск ошибок

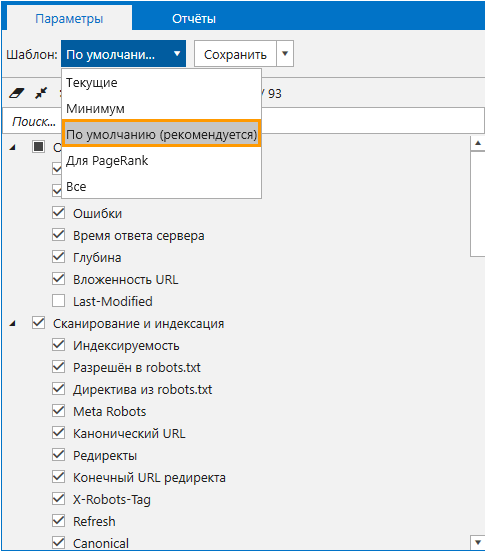

Netpeak Spider позволяет проверять сайт на все самые распространённые ошибки внутренней оптимизации, которые препятствуют успешному продвижению сайта. Чтобы проверить проект, вам не нужно выбирать каждый параметр вручную, для аудита у нас есть уже встроенный шаблон параметров «По умолчанию» → вам достаточно его выбрать, а затем запустить сканирование.

После окончания сканирования все найденные ошибки вы найдёте на вкладке «Отчёты» → «Ошибки».

У Netpeak Spider есть бесплатная версия без ограничений по времени, в которой вы сможете провести аудит сайта и увидеть, какие ошибки на нём есть. Также во Freemium-версии доступны и другие базовые функции программы.

Чтобы начать пользоваться бесплатным Netpeak Spider, просто зарегистрируйтесь, скачайте и установите программу — и вперёд! 😉

2. Настройки в программе перед запуском сканирования

Предлагаю рассмотреть основные настройки программы перед запуском сканирования:

- режим сканирования;

- количество потоков сканирования;

- User Agent;

- параметры для анализа;

- прокси

2.1. Режим сканирования

Netpeak Spider позволяет сканировать как и полностью сайт, так и отдельные страницы / раздел. Давайте разберёмся, как настраивать режимы сканирования

- Сканирование всего сайта предусмотрено по умолчанию, поэтому ничего перенастраивать не нужно — достаточно поместить адрес сайта в строку и запустить сканирование.

- Чтобы сканировать конкретный раздел сайта, перейдите в «Настройки» → «Основные» и поставьте «галочку» возле пункта «Сканировать внутри раздела». Этот режим стоит активировать, когда структура сайта и структура URL выстроены логично и совпадают.

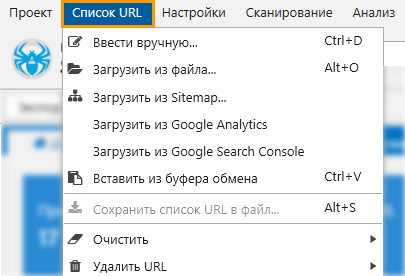

- Для сканирования определённого списка URL вам нужно его перенести в программу. Для этого есть четыре способа: ввод вручную, вставка из буфера обмена, загрузка из файла и загрузка из Sitemap. Все эти функции вы можете найти в меню «Список URL».

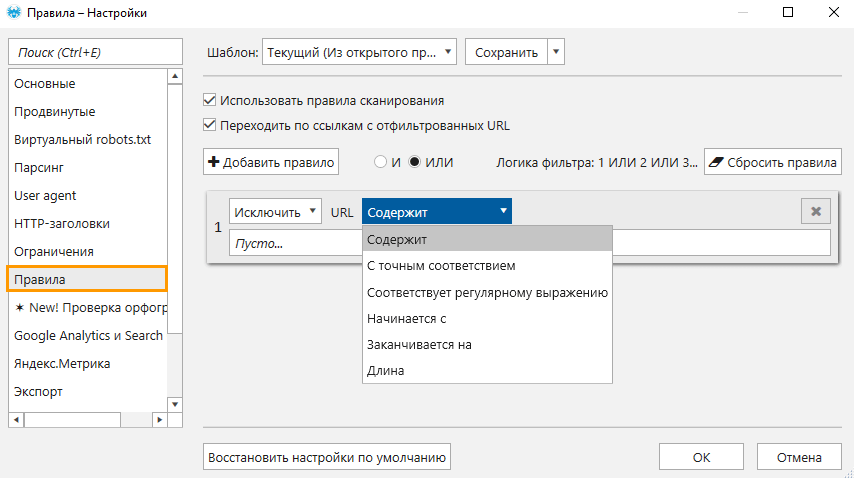

- Также в программе можно просканировать страницы, которые объединены по какому-то признаку. Задаются эти настройки в разделе «Правила» → укажите критерии и типы URL, которые вы хотите учитывать или исключить при сканировании.

Подробнее о настройках правил сканирования вы можете узнать в этой статье.

Подробнее о настройках правил сканирования вы можете узнать в этой статье.

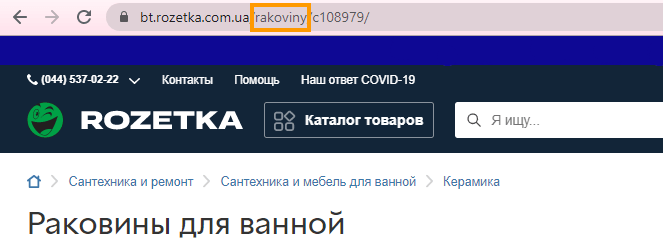

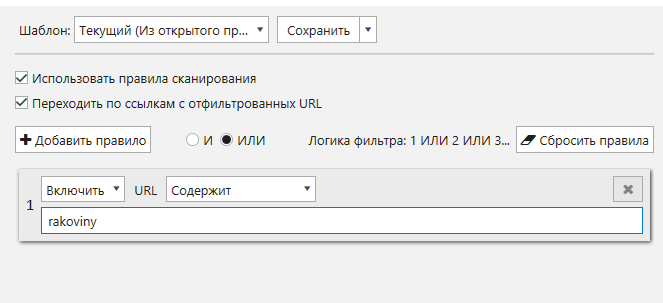

Покажу на примере: вам из всего сайта нужно просканировать страницы интернет-магазина, на которых есть определённый товар, например, раковина.

Если на сайте есть настроенные ЧПУ, то сделать это будет очень просто:

- Используйте в качестве правила слово из раздела URL.

- Задайте правила на соответствующей вкладке настроек программы.

- Сохраните настройки и просканируйте сайт.

2.2. Параметры сканирования

От выбранных параметров будет зависеть, на какие ошибки краулер будет проверять сайт. Также установленные параметры влияют на скорость сканирования и на анализ данных.

Чтобы посмотреть, на какие ошибки проверяет тот или иной параметр, кликните на его название и откройте панель «Информация». Краулер Netpeak Spider анализирует 70+ параметров на 100 ошибок!

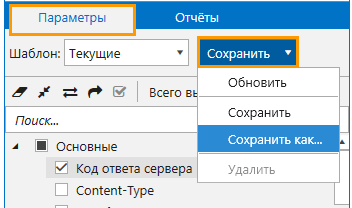

Также все установленные вами настройки и параметры вы можете сохранить как шаблон и использовать его в дальнейшем.

Для этого после всех настроек на боковой панели рядом с окном «Шаблон» выберите «Сохранить как», дайте название своему шаблону и нажмите на кнопку «OK».

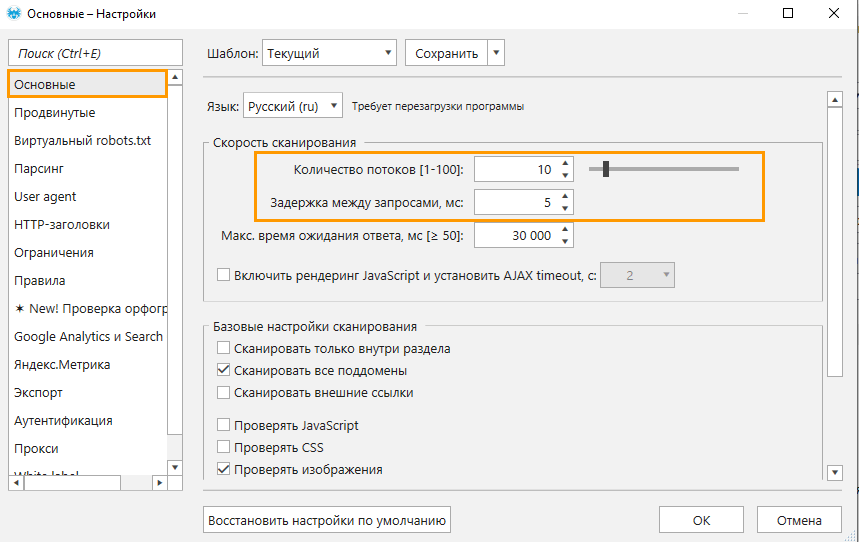

2.3. Количество потоков

Скорость сканирования — это важный аспект при сканировании крупного сайта. На скорость влияют такие факторы как:

- мощность сервера сайта,

- ресурсы устройства,

- количество потоков сканирования.

Однако не всегда все три фактора зависят от нас. Единственный, на который мы можем повлиять в любой момент — это скорость сканирования, так как в Netpeak Spider эта настройка доступна перед и во время анализа! Для этого необходимо установить количество потоков. Для установки откройте основные настройки программы и задайте нужное значение. Но будьте внимательны: большое количество потоков может привести к проблемам с сервером сайта. Чтобы найти оптимальное количество, регулируйте это значение прямо время сканирования.

Также советуем выставить задержку между запросами, если сайт сильно чувствительный или использует защиту от парсеров.

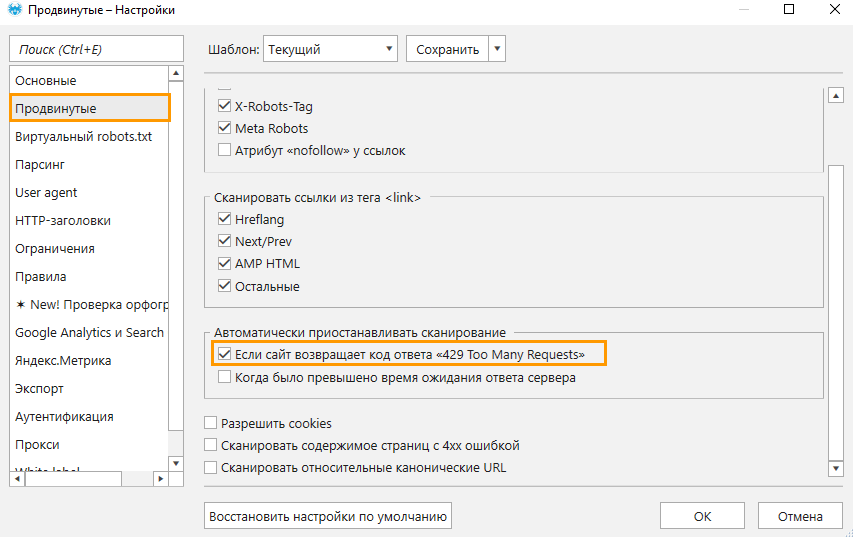

И ещё вы можете включить функцию, которая автоматически останавливает анализ, если сайт возвращает код ответа 429. Её вы найдёте в продвинутых настройках краулера

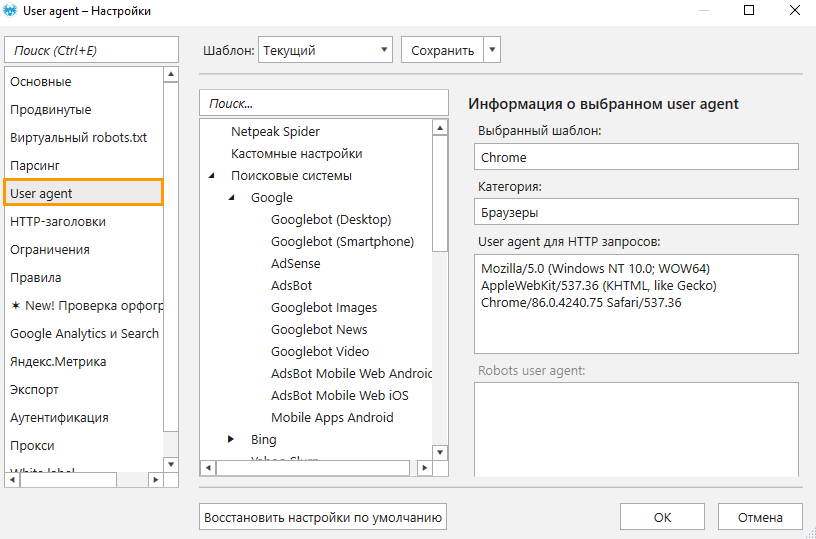

2.4. User Agent

С помощью User Agent вы можете тестировать доступность сайта для:- различных браузеров,

- поисковых роботов,

- десктопных, мобильных и других устройств.

Поэтому в зависимости от выбранного User Agent, результаты сканирования могут отличаться.

По умолчанию программа сканирует сайты с использованием юзер-агента Google Chrome, поэтому рекомендуем использовать именно его.

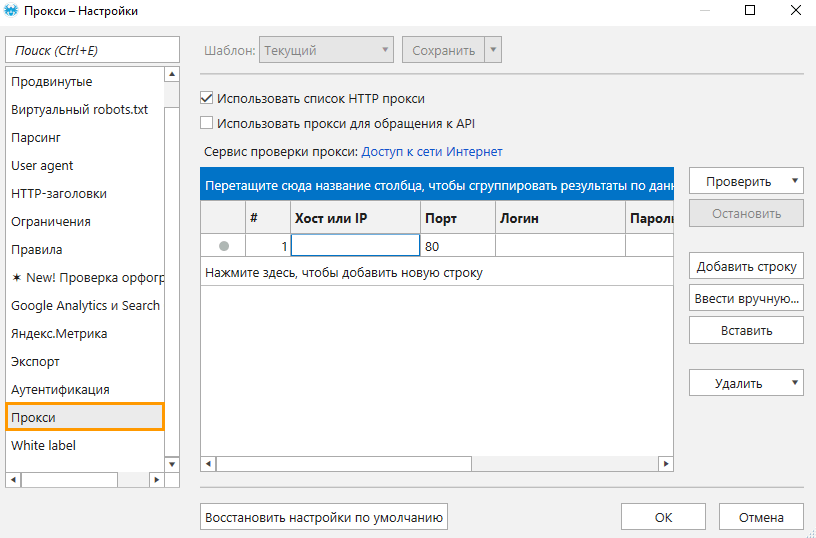

2.5. Настройка прокси

При сканировании сайтов-гигантов на большом количестве потоков могут возникнуть проблемы из-за установленной защиты, которая не позволит провести сканирование сайта. Обойти это можно с помощью нескольких прокси: они сымитируют естественный приток пользователей. Однако стоит помнить, что прокси снижают скорость сканирования.

Чтобы добавить прокси в Netpeak Spider, проделайте следующее:

- Откройте вкладку «Прокси» в настройках.

- Активируйте чекбокс «Использовать список HTTP-прокси».

- Поместите список прокси любым удобным способом: вручную или вставьте из буфера обмена.

- Сохраните все настройки и запустите сканирование.

3. Анализ результатов сканирования

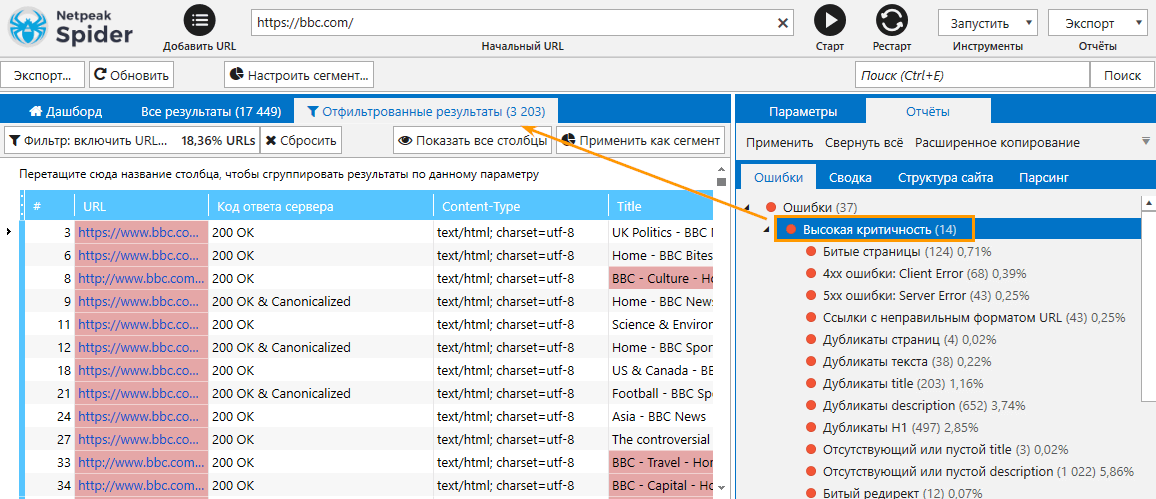

Как вы понимаете, с данными гигантских сайтов справиться непросто. Поэтому советуем вам фильтровать и сегментировать результаты сканирования! И да, эти обе функции доступны в Netpeak Spider, разберём подробнее.

3.1. Фильтрация и сегментация

В краулере вы можете сегментировать и фильтровать данные по любому признаку. Эти функции позволят упростить вам работу с крупными проектами, чтобы анализировать конкретную выборку данных.

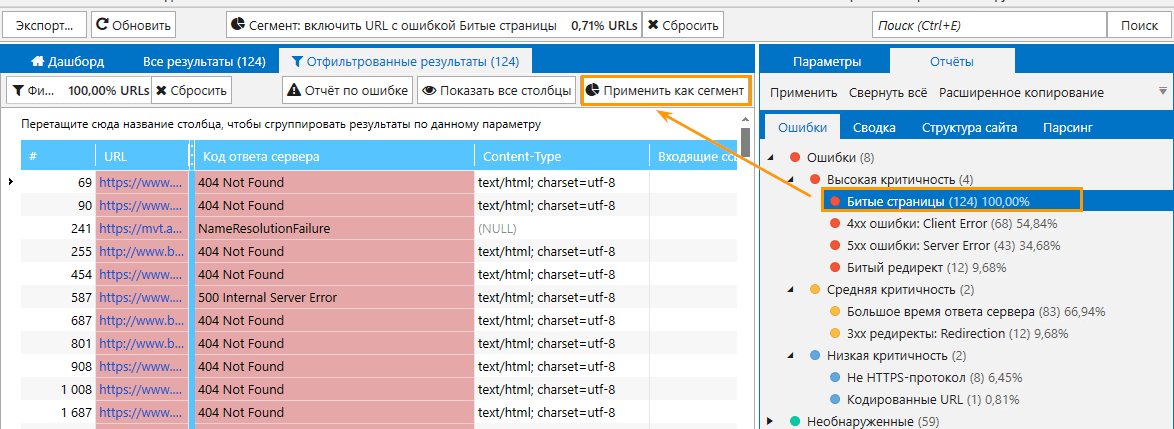

Например, чтобы посмотреть, какие страницы содержат критические ошибки, нужно в отчёте по ошибкам нажать на строку «Высокая критичность» → в основном окне программы вы увидите таблицу с отфильтрованными результатами.

Если вам необходимо отделить конкретную выборку данных и работать только с ней, вам поможет сегментация данных.

Сегментация отличается от фильтрации тем, что сегментация как бы ограничивает все действия и представление данных в программе определённым набором страниц. Все остальные страницы за пределами этого фильтра уже не учитываются. Для настройки сегмента сначала примените любой фильтр, а затем кликните на кнопку «Применить как сегмент»:

После этого все действия программы будут ограничиваться только теми страницами, которые соответствуют выбранному вами фильтру.

Чтобы отключить сегмент, нажмите на кнопку «Сбросить».

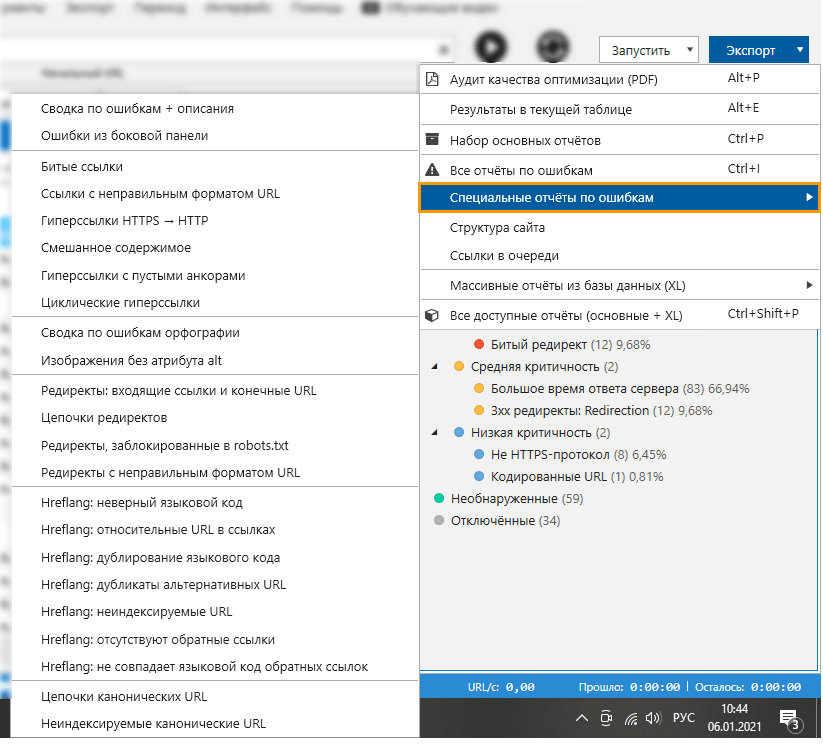

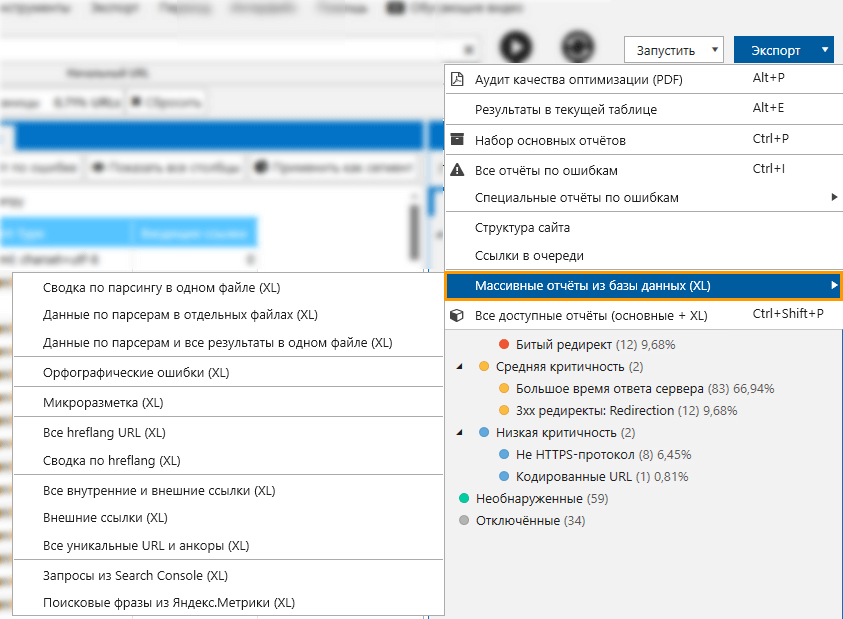

3.2. Экспорт отчётов

Вы можете экспортировать любой созданный вами отчёт из таблицы отфильтрованных результатов → для этого просто нажмите на кнопку «Экспорт» над таблицей или в меню «Экспорт» → «Результаты в текущей таблице». Также в программе доступна выгрузка разных видов отчётов, в том числе специальные отчёты по ошибкам и массивные отчёты из базы данных.

Подводим итоги

Сканирование сайтов-гигантов — ресурсозатратный процесс, который требует также много времени, а особенно при анализе результатов сканирования. В этом посте мы разобрали, как с помощью Netpeak Spider проводить аудит и работать с результатами.

Расскажите, а какие вы методы применяете при проведении аудита крупных сайтов?