Санкции поисковых систем: как не попасть в «чёрный список» Google

Мануалы

Случается так, что SEO-оптимизация приводит к нежелательным результатам. Позиции сайта снижаются, а некоторые либо все страницы исчезают из поисковой выдачи. При таких проблемах следует проверить, не наложили ли поисковые системы на сайт санкции. Что это такое, и как с этим бороться, я расскажу в посте.

- 1. Что такое санкции поисковых систем

- 2. Чем отличаются ручные от автоматических санкций

- 3. Что делать, если сайт попал под фильтры

- Подводим итоги

1. Что такое санкции поисковых систем

Санкции поисковиков — это меры, которые те предпринимают за нарушения их правил ради быстрого продвижения и получения топовых позиций в выдаче. К мерам относится удаление страниц сайта из выдачи либо существенное снижение позиций. Как правило, такая ситуация возникает при осознанных попытках владельцев сайта манипулировать выдачей:

- покупка SEO-ссылок;

- публикация неуникального или низкокачественного контента;

- применение действий, направленных на искусственный рост ссылочной массы или улучшение поведенческих факторов.

Однако причиной накладывания санкций могут также стать недобросовестные действия конкурентов.

1.1. Фильтры Google

Под фильтры Google может попасть любой сайт, который нарушает рекомендации для вебмастеров и совершает различного рода манипуляции:

- Публикация некачественного контента. На ресурсе должны отсутствовать бесполезные тексты, автоматически сгенерированные специальными программами и с обилием ключей. Нельзя также копировать статьи и мультимедийный контент с других сайтов без их дополнения значимой информацией.

- Использование платных ссылок для продвижения.

- Маскировка (клоакинг) — различается контент для поисковых роботов и обычных посетителей.

- Использование скрытой переадресации — все пользователи (либо только посетители, использующие мобильные устройства) перенаправляются на веб-страницу, которая отличается от отображаемой в поисковой выдаче. Поисковый робот при этом продолжает анализировать исходную страницу.

- Добавление скрытого текста или ссылок — на страницах есть невидимый пользователям контент, содержащий ключи либо ссылки. Текст при этом скрывается с помощью стилей CSS или определённых характеристик шрифта: сливающегося с фоном цвет, нулевой размер и т.д.

- Создание дорвеев — когда сайт продвигается с помощью оптимизированных под определённые ключевые слова бесполезных ресурсов, которые перенаправляют пользователей на нужный URL-адрес.

- Использование сайта для мошеннических действий: похищения персональных данных посетителей, установки вирусных программ, изменения настроек браузера пользователей без их ведома и т. д.

- Добавление некорректной микроразметки для расширенных сниппетов в результатах поиска. Например, в микроразметке размещена информация, не соответствующая содержимому страницы, поддельные отзывы, запрещённый контент, и есть прочие нарушения.

- Используются автоматические запросы к Google для получения сведений о рейтинге страниц сайта. Например, специальное программное обеспечение для определения позиций ресурса в поисковой выдаче по определённым запросам.

Наиболее распространённые автоматические фильтры Google:

- Google Penguin — кодовое название фильтра, появившегося в 2012 году для борьбы с нечестным наращиванием внешних ссылок. Фильтр пессимизировал в результатах выдачи ресурсы, использующие ссылочный спам и переоптимизированные анкорные тексты. С 2016 года данный фильтр — часть основного ядра поисковых алгоритмов Google, которое обновляется в реальном времени без уведомления вебмастеров об апдейтах. С этого момента фильтр перестал снижать позиции за использование ссылочного продвижения, а начал просто игнорировать неестественные ссылки. Однако при активном спаме сотрудники Google могут наложить меры вручную.

- Google Panda — фильтр создан в 2011 году, чтобы удалять из индекса веб-страницы с низкокачественным контентом, к которому относится:

- Содержимое, скопированное с других ресурсов.

- Автоматически сгенерированные бессмысленные тексты.

- Обилие ключевых слов в текстах, мета-тегах, атрибутах alt.

- Большое количество рекламы, ухудшающее юзабилити сайта.

- Высокий показатель отказов.

При наличии подобных проблем даже на некоторых страницах под фильтр может попасть проект полностью. Если большинство страниц хорошего качества, позиции снижаются только по части запросов.

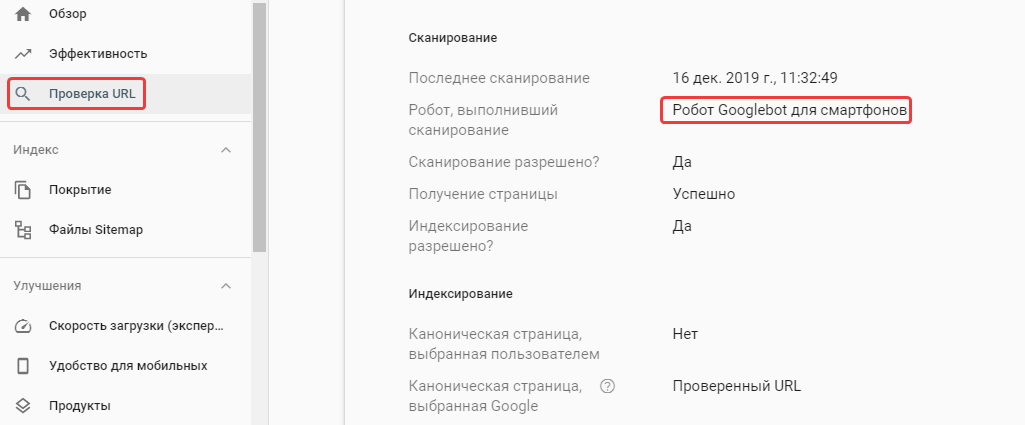

- Mobile-first indexing — обновление алгоритма, с помощью которого c июля 2019 года Google индексирует все новые сайты с приоритетом мобильного контента, то есть первоочерёдная индексация совершается ботам для смартфонов.

Старые сайты переходят на мобильный индекс по мере их готовности с соответствующим оповещением в Google Search Console. Проверить, как сканируются страницы, можно инструментом «Проверка URL» в сервисе.

У сайтов, не имеющих мобильной версии, могут снизиться позиции, поскольку в приоритете показ адаптированных под смартфоны ресурсов. Реализовывается это разными способами — адаптивной вёрсткой, мобильной версией на субдомене, динамическим показом.

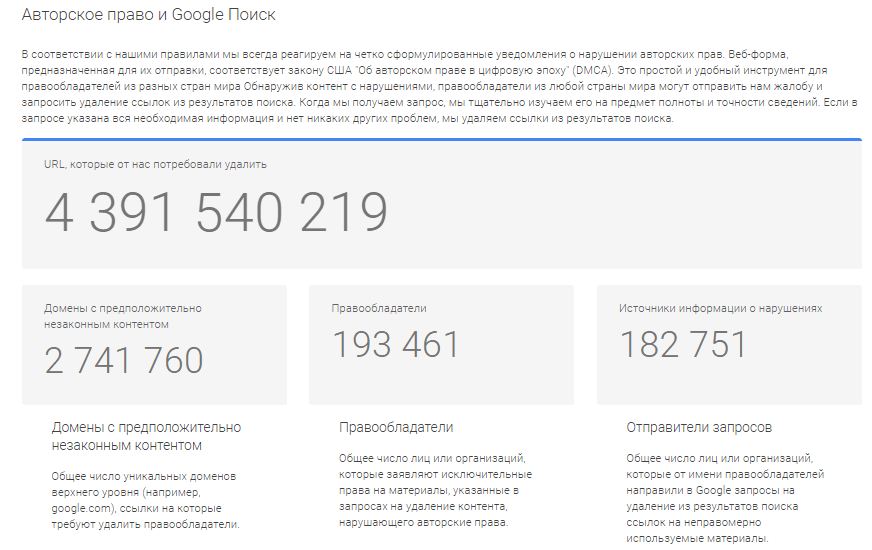

- DMCA-фильтр (Pirate) — удаление контента в связи с нарушением авторских прав. При поступлении жалоб от правообладателей страницы сайта удаляются из поисковой выдачи.

- Fred — обновление алгоритма, целью которого было исключение страниц, не соответствующих требованиям поисковой системы, из поиска. В основном под удар попали сайты с обилием рекламы и малополезным неуникальным контентом. Резкое снижение трафика может свидетельствовать о том, что сайт попал под данный фильтр.

- RankBrain — компонент алгоритма, использующий машинного обучение. Основная цель обновления — определить истинное намерение пользователя, чтобы предоставить максимально релевантные результаты выдачи. Алгоритм интерпретирует слова в запросе, расположение пользователя, персональные предпочтения. Чтобы подстроиться под алгоритм, необходимо писать хорошие информативные тексты, которые содержат различные синонимы и словоформы, работать над удобной структурой и навигацией сайта.

- Hummingbird (Колибри) – обновление алгоритма 2013 года, благодаря которому поисковая система различает «смысл» и анализирует не отдельные слова в запросе, а всю фразу целиком. Это позволяет формировать наиболее релевантную выдачу.

2. Чем отличаются ручные от автоматических санкций

Санкции поисковых систем бывают автоматические и ручные. О наличии последних можно узнать в сервисах ПС для вебмастеров, а вот вторые «приходят» без предупреждения. Ручные санкции накладываются при поступлении сигнала от поисковых алгоритмов либо жалобах от других пользователей. Вебмастер видит соответствующее оповещение.

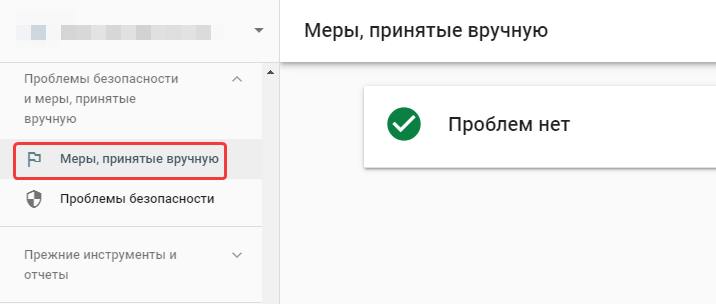

Как узнать, что сайт под фильтром Google?Сообщение от Google отображается в Search Console во вкладке «Меры, принятые вручную».

Информация об автоматических фильтрах не отображается в данных разделах, однако в системах аналитики видно резкое снижение посещаемости сайта из-за падения позиций, уменьшение количества страниц в индексе и прочие показатели, косвенно свидетельствующие о санкциях поисковых систем.

3. Что делать, если сайт попал под фильтры

Сначала требуется устранить факторы, которые вызвали санкции поисковиков. Например, если сайт попал под фильтр Пингвин либо Минусинск вследствие закупки ссылок на бирже, нужно деактивировать их.

Если нет возможности удалить некачественные ссылки, либо они были размещены не владельцами сайта, а недобросовестными конкурентами, обратитесь к администрации сайтов-доноров, попросив их убрать ссылки. Если это не сработало, воспользуйтесь инструментом «Отклонение ссылок», чтобы Google перестал их учитывать.

Для вывода проекта из-под фильтров устраните другие нарушения и проведите основательную работу над повышением качества сайта. После этого запросите проверку → в Search Console «Запросить проверку». Подождите несколько недель, если проблема не решится, отправьте в техническую поддержку поисковиков письма с подробным описанием тех мер, которые вы предприняли, чтобы устранить все нарушения на ресурсе и попросите специалистов проверить сайт.

Подводим итоги

Поисковые системы накладывают фильтры на проекты, которые пытаются обманным путём улучшить свои позиции. Ресурсы попадают под фильтры в автоматическом режиме, либо их вручную накладывают специалисты поисковых систем. О ручных санкциях отображаются оповещения в системах аналитики, а узнать, что проект попал под автоматические фильтры можно по стремительному ухудшению позиций и уменьшению количества посещений.

Помимо снижения позиций и удаления из выдачи определённых страниц, из-за фильтров ресурс может быть полностью исключен из индекса. Для исправления ситуации необходимо устранить нарушения требований поисковиков, исходя из конкретных санкций — удалить SEO-ссылки, убрать лишние ключевые слова, исключить материалы, нарушающие авторские права, и так далее.

А вы сталкивались с санкциями поисковых систем? Как справлялись? Делитесь опытом в комментариях 😊